텍스트 명령어 입력만으로 최장 20초 길이의 동영상을 생성하는 인공지능(AI) 서비스 ‘소라(Sora)’가 2024년 12월 9일 출시됐습니다. 앞서 2월에 일부 이용자를 대상으로 비공개 테스트를 진행했는데 이제 정식 서비스로 제공되고 있습니다. 미국 기업 오픈AI가 챗GPT 유료 구독 서비스 이용자들에게 글쓰기와 이미지 생성 기능에 더해 이제 동영상 생성 기능까지 제공하기 시작한 것입니다.

소라는 추상적인 예술 작품이나 점토 등 소재를 이용해 실사 촬영 이미지로 애니메이션을 만드는 ‘클레이메이션’ 스타일 영상 제작에도 뛰어난 성능을 보여 주고 드론으로 촬영한 듯한 풍경을 사실적으로 구현하는 특징을 보여 줬습니다. ‘길을 걷는 사람’처럼 일상적이고 범용적인 표현으로 명령어를 입력해 초기 결과물을 얻은 다음 추가 명령어로 영상 속 배경과 상황을 유지한 채 등장 인물의 외모나 의상을 바꾸는 편집 기능(리믹스)을 지원하고요.

이걸로 누구나 장식적인 역할 또는 단순한 주제를 함축적으로 표현하는 진짜 같은 동영상을 만들어낼 수 있게 됐습니다. 촬영할 장소를 확보하고 소품을 배치하고 인물을 섭외해 등장시키고 전문가의 촬영과 편집을 거치는 수고나 비용을 들이지 않고요. 2년 전 챗GPT가 출시되면서 비전문가 개인이 온갖 주제에 대해 무난하게 설명하고 프로그래밍 지식 없이 간단한 코드를 짤 수 있게 된 것처럼, 이제는 전문 기술 없이 간단한 영상을 스스로 만들어 쓸 수 있는 시대가 열렸네요.

텍스트로 동영상 생성하는 AI 기술 경쟁

빅테크 기업 간에 개인 소비자를 겨냥한 동영상 생성 AI 서비스 기술 개발 경쟁이 치열합니다. 빅테크 글로벌 사회관계망서비스(SNS) 페이스북·인스타그램을 운영하는 미국 기업 메타는 2024년 10월 사용자가 입력한 명령에 따라 최장 16초 길이 영상을 만들어내는 ‘무비 젠’을 선보였습니다. 무비 젠은 2025년 인스타그램 서비스에 적용될 것으로 알려졌는데, 이용자들이 ‘릴스’같은 쇼트폼 콘텐츠를 더 다채롭게 만들어 올릴 수 있도록 유도하기 위한 포석으로 짐작됩니다. 구글도 자회사 딥마인드에서 개발한 영상 생성 AI 모델 ‘비오(Veo)’를 유튜브 ‘쇼츠’ 서비스에 통합할 예정이라고 해요. 쇼츠 크리에이터가 자신이 표현하고자 하는 새로운 콘셉트를 시각화하거나 비현실적인 창작물을 배경으로 한 장면을 활용해 짤막한 영상을 빠르게 만들고 SNS에 올릴 수 있게 할 것으로 예상됩니다.

구글은 비오를 자사 서비스에 활용하는 것을 넘어 다른 기업들이 AI 기술을 기반으로 영상을 제작할 수 있도록 하기 위해 머신러닝·AI 응용 서비스 개발 플랫폼인 ‘버텍스 AI’의 모델로도 제공하기 시작했다고 합니다. 오픈AI와 협력해 그 AI 기술을 기업용 클라우드 서비스 기반 제품으로 판매하고 있는 마이크로소프트나, 클라우드 서비스 시장에서 구글, 마이크로소프트와 경쟁하고 있는 아마존 등이 자체 클라우드 서비스에 또 다른 기업용 AI 기반 영상 생성 기술을 선보이고 경쟁에 나서는 것도 시간 문제겠지요.

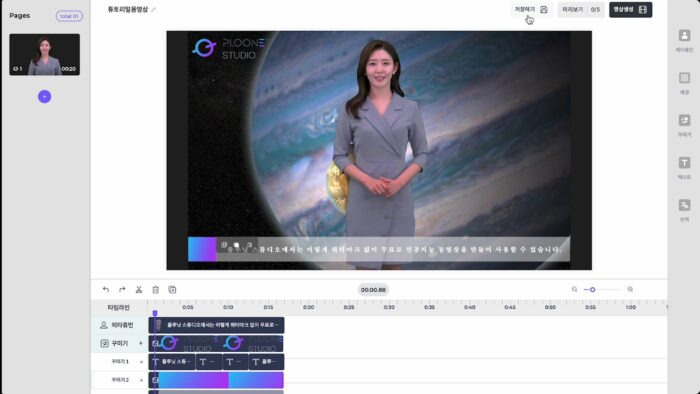

앞서 국내에서 개발된 생성 AI 기반 영상 제작 서비스와 플랫폼도 있습니다. 생성 AI 모델을 개발하고 미국과 한국에 AI 검색 서비스 ‘구버’를 출시한 솔트룩스가 자회사인 플루닛(Ploonet)을 통해 선보인 ‘플루닛 스튜디오’입니다. 오픈AI 소라와 빅테크 기업들의 생성 AI 기반 영상 제작 기술이 개인 소비자 대상 쇼트폼 콘텐츠 제작과 같은 영역을 겨냥한다면, 플루닛 스튜디오는 정보나 메시지를 효과적으로 전달하기 위한 영상 콘텐츠 제작 수요에 더 초점을 맞췄다는 차이점이 있습니다.

생성 AI로 가상의 피사체를 더 실감나게

플루닛 스튜디오는 사전 제공되는 가상 인간(메타휴먼)을 가상의 공간에 배치하고 이 등장인물이 전달해야 할 정보나 메시지를 텍스트로 입력하고, 이에 어울리는 인물의 말하기 속도와 어조를 조절하는 기능을 제공합니다. 인물이 등장하는 공간 배경에 적절한 이미지, 효과음, 텍스트도 표현할 수 있고요. 마치 파워포인트 슬라이드를 만들듯이 가상 인간과 공간의 표현을 배열하고 조정하면서 정보 전달 중심의 영상 콘텐츠를 제작할 수 있게 고안됐죠.

플루닛 스튜디오에도 스크립트 작성 과정의 부담을 덜어줄 수 있도록 챗GPT 텍스트 생성 기능이 통합돼 있고, 스크립트에 맞는 가상 인간의 음성과 제스처 변화를 구현하는 데에는 음성 및 영상 생성 AI 기술이 활용됐습니다. 결과물을 얻기 위해서는 상대적으로 인간의 수작업이 더 많이 필요할 뿐이죠. 향후 이미지, 음성, 영상 생성 AI 기술의 근본적인 발전이 이뤄지고 비용이 저렴해진다면, 플루닛 스튜디오와 같은 가상 인간 기반의 정보 전달형 AI 기반 영상 제작 도구의 활용 난도가 더 낮아지고 고품질 결과물을 만들기 위한 작업도 한결 더 수월해질 것입니다.

그 변화 방향은 전 세계 수많은 사진사와 그래픽 디자이너들이 애용하고 있는 이미지 편집 프로그램 ‘포토샵’이 진화하고 있는 모습을 통해 엿볼 수 있습니다. 포토샵에는 예전부터 필터를 적용하거나 사물의 색상, 크기, 위치를 교정하는 AI 기술 기반 이미지 인식 및 생성 기능이 탑재되고 있었는데요. 2023년에는 ‘파이어플라이’라는 생성 AI 모델 연계 서비스가 기존 유료 제품에 추가되고 ‘텍스트를 이미지로(Text to Image)’라는 기능이 제공되기 시작했습니다. 이에 포토샵에서 마치 챗GPT처럼 텍스트 명령을 입력해 이미지 생성을 요청할 수 있을 뿐 아니라, 숙련도가 낮은 사용자가 불러 놓은 이미지의 색상 변경, 배경 교체, 그래픽 효과나 질감 표현 작업을 간편하게 할 수 있게 됐죠.

또한 플루닛은 실제 인물의 동작을 촬영하고 그 음성을 녹음한 데이터로 그의 외모와 몸짓, 음성을 본딴 가상 인간을 제작하는 기술과 이 가상 인간에게 텍스트 명령을 입력해 그 내용에 맞는 음성과 입모양, 몸짓을 시청각적으로 구현하는 생성 AI 기술을 보유했습니다. 음성과 영상 생성 AI 기술이 더 고도화하면 실제 인물의 음성 녹음과 외모, 동작 녹화 데이터를 더 적게 쓰면서도 단시간에 더 자연스러운 음성과 영상으로 표현되는 가상 인간을 제작할 수 있게 되고, 플루닛 스튜디오의 범용성이 더욱 높아지겠네요. 이미 제작한 가상 인간의 의상을 바꾸거나 새로운 동작을 추가하거나 목소리의 특징을 더 세부적으로 제어할 수 있을 것으로도 기대됩니다.

모든 동영상 콘텐츠 시청하기, 24시간이 모자라

이처럼 국내외 크고 작은 기업들이 앞다퉈 생성 AI 기술을 활용해 더 짧은 시간에 더 많은 영상을 만들어내는 시대가 이미 열리고 있는데요. 정작 이러한 영상을 시청하고 소비할 수 있는 사람들의 시간에는 한계가 있습니다.

사진 및 영상 전문가 대상 정보제공 사이트인 포튜토리얼(Photutorial)에 마틱 브로즈(Matic Broz)가 2024년 2월 18일 게재한 포스팅을 보면 당시 유튜브에는 쇼츠 영상 8억2600만개를 포함한 동영상 39억개가 올라가 있었다고 해요. 1년 전에 31억건이었는데 그 새 8억건이 늘어난 겁니다. 2023년 기준으로 유튜브에 매일 240만개(한 시간마다 10만개) 영상이 올라갔고요. 유튜브 영상의 평균 길이는 12분 26초로, 39억개에 이르는 모든 영상을 한 순간도 쉬지 않고 모든 영상을 순차적으로 시청하려면 420억분, 햇수로 환산하면 8만1500년 정도 걸린다고 합니다.

그나마 이 계산도 유튜브에 더 이상 아무런 영상이 새로 올라오지 않는다고 가정해야 하는 건데, 그럴 리는 없죠. SNS 콘텐츠 크리에이터를 위한 정보 사이트 튜브필터(Tubefilter)에 제임스 헤일(James Hale)이 2019년 5월 7일 쓴 포스팅을 보면 그때 이미 유튜브에는 매일 72시간(한 시간마다 3시간짜리) 분량의 영상이 새로 올라오고 있었어요. 모든 영상을 쉬지 않고 ‘3배속’ 재생으로 시청해야 그나마 새로 올라온 영상을 그때그때 소화할 수 있는 수준이고, 그렇게 해도 이미 올라온 영상까지 볼 수는 없는 셈입니다.

현존하고 앞으로 만들어질 모든 콘텐츠를 소비할 수 있다고 믿는 사람은 아무도 없지만, 어쨌든 콘텐츠가 폭발적으로 증가하고 있다는 건 누구나 아는 사실인데요. 특히 영상은 실제로 재생해서 시청하지 않으면 내용을 파악하는 데 제약이 심하다는 특성이 있다는 것이 문제입니다. 그래서 이제 영상의 내용 자체를 텍스트로 요약해 주는 AI 서비스도 주목받고 있죠. 모든 사람들이 방대한 영상을 일일이 시청하지 않고 빠르게 내용을 파악하고자 하는 수요가 있고, 앞으로 더 늘어날 수밖에 없으니까요.

사람 대신 영상 읽어주는 AI 서비스 우후죽순

실제로 구글에서 ‘영상으로 텍스트를 생성하는 AI(video to text gen ai)’라는 검색어를 입력하면 저마다 이러한 기술을 제공한다고 자처하는 AI 업체의 웹사이트 목록이 검색 결과로 끝없이 나옵니다. 이 분야는 유명한 빅테크 기업이 아니라 음성과 영상 데이터 처리에 특화한 AI 기술을 보유한 스타트업이 대거 진출해 있는 것으로 보입니다.

미국 스타트업 브라스크(Brask)는 ‘유튜브 영상 음성 받아쓰기’와 최장 5시간 길이의 영상 내용을 텍스트로 변환, 번역하는 서비스를 제공한다고 주장합니다. 또 다른 미국 기업 카타라테크(Katara Tech)도 비디오와 오디오 파일을 텍스트로 자동 변환하는 서비스, 또는 동영상 음성에 맞는 원어 및 외국어 자막을 자동 첨가하는 서비스를 제공한다고 주장하고요. 몇 분 만에 검색된 10여개 기업들이 제공할 수 있다고 주장하는 서비스가 이와 크게 다르지 않습니다. 실제로 각 서비스의 경쟁력이나 결과물의 특징, 요구하는 비용은 차이가 있겠지만 언뜻 보기에도 이에 대한 수요가 크게 일어나고 있음을 짐작할 수 있죠.

인터넷에서 풍부한 텍스트와 이미지 데이터를 활용해 영상으로 만들어내는 AI 기술이 앞서 등장했고 이제 영상을 텍스트로 재구성하는 등 반대 흐름의 기술에 대한 수요도 나타나고 있습니다. 이처럼 입력 데이터와 결과물 유형이 서로 다르거나 다양한 입력 데이터를 모두 분류하고 가공 처리할 수 있는 AI 기술을 지원하는 멀티 모달(Multi modal) AI가 빠르게 일상으로 다가오고 있고요. 텍스트를 처리한 결과를 텍스트로만, 이미지나 음성 등을 처리한 결과를 이미지나 음성 등으로 기존 형태에 한정해 내놓을 수 있도록 만든 것을 싱글 모달(Single modal) AI 모델이라고 하는데요. 과거에는 단일 유형의 콘텐츠를 처리하는 것만으로도 품질 경쟁이 일어날 만큼 싱글 모달 AI 모델 기술을 고도화하는 과정이 필요했지만, 앞으로는 멀티 모달 AI 기술 개발과 이를 활용한 서비스 경쟁이 더욱 활발해질 것으로 전망됩니다.

최신 스마트폰에 탑재되는 음성 통화 내용 자동 텍스트 변환 기능이나 기본 카메라 앱을 켜서 사물을 비췄을 때 곧바로 해당 장소, 제품에 관련된 정보를 검색해 주는 기능도 멀티 모달 AI 모델 기술에 기반합니다. 멀티 모달 AI 모델 기술이 더 발전하고 모델을 훈련, 추론하는 데 드는 비용이 상대적으로 저렴해지면 텍스트를 영상으로 생성하고, 영상을 텍스트로 재구성하는 서비스가 더 빠르게 보급될 수 있을 것입니다. 이전까지는 고난도 영역으로 인식되던 이미지와 음성의 편집, 이들을 조합한 영상의 제작과 가공을 위한 진입 문턱은 낮아지고, 더 많은 사람들이 더 많은 멀티미디어 콘텐츠를 만들어 배포하겠죠. 그럴수록 여기에 소개한 유튜브 등 영상 플랫폼에서 내용을 분석하고 빠르게 텍스트로 정리, 요약해 주는 기술 또한 중요해질 것 같습니다. 적지 않은 사람들이 인터넷 동영상 강의를 듣고 유료 스트리밍 영상 콘텐츠를 시청할 때 정속보다 더 빠른 재생 속도를 자연스럽게 선택하고 있는데요. 앞으로 더 정확하고 빠르게 내용을 텍스트로 옮겨 주는 AI 서비스나 기능이 제공된다면 그러한 기능을 통해서라도 어떤 영상이 소비되고 있는지 파악하는 방법이 필요해지겠네요.

—

솔트룩스 네이버블로그 ‘인공지능 인사이트’ 필진으로서 작성한 서른 한 번째(마지막) 정기 원고. 250109 솔트룩스 네이버블로그 포스팅으로 게재됨. 250127 개인 블로그에 원문 비공개로 올림. 250425 공개로 전환.